传感器误差模型

对于理想的 IMU 三轴加速度计两两正交,构成一个正交的三轴直角坐标系,加速度计每一轴单独测量该轴的加速度,而陀螺仪则测量该轴的角速度。在实际的真实 IMU 中由于制造工艺的误差,三个坐标轴不可能完全两两正交,加速度计与陀螺仪的坐标系也不会完全重合,并且单个传感器也不是完全精确的。在实际器件中将数字输出量转化为实际物理量的 scale 参数在不同轴上是不同的,但是设备生产商都会提供一个默认的 scale 参数用于转换所有轴的数据,而且数字量的输出还会受到零偏(传感器在静止情况下也会有微小量的输出)的影响,这些就是造成 IMU 传感器的系统误差。

我们取实际器件的加速度计坐标系为 AF, 陀螺仪坐标系为 GF,根据 AF 和 GF 分别建立对应的正交坐标系 AOF 和 GOF,其建立约束为

- AOF 的 x 轴与 AF 的 x 轴重合。

- AOF 的 y 轴位于 AF 的 x 与 y 轴的平面中。

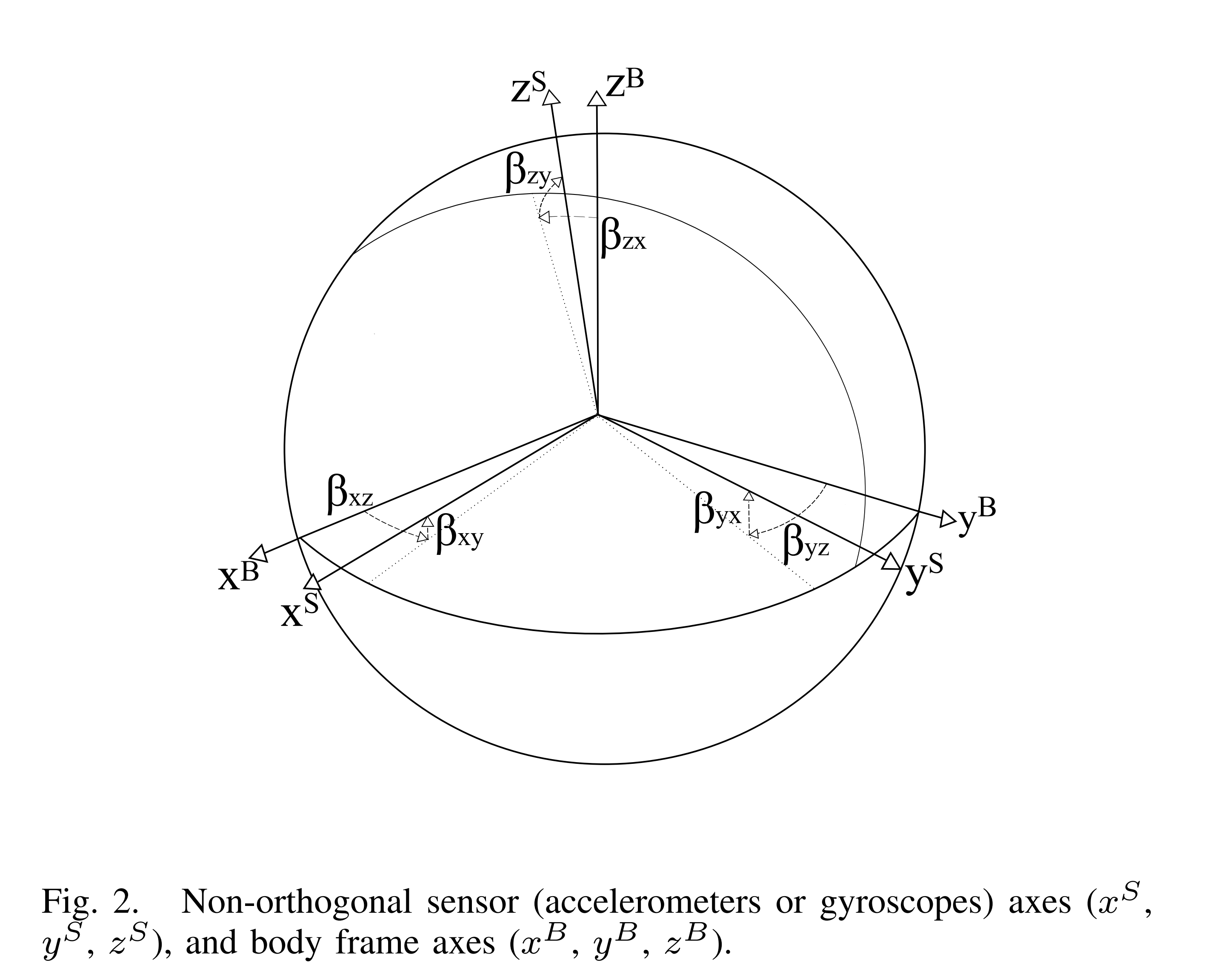

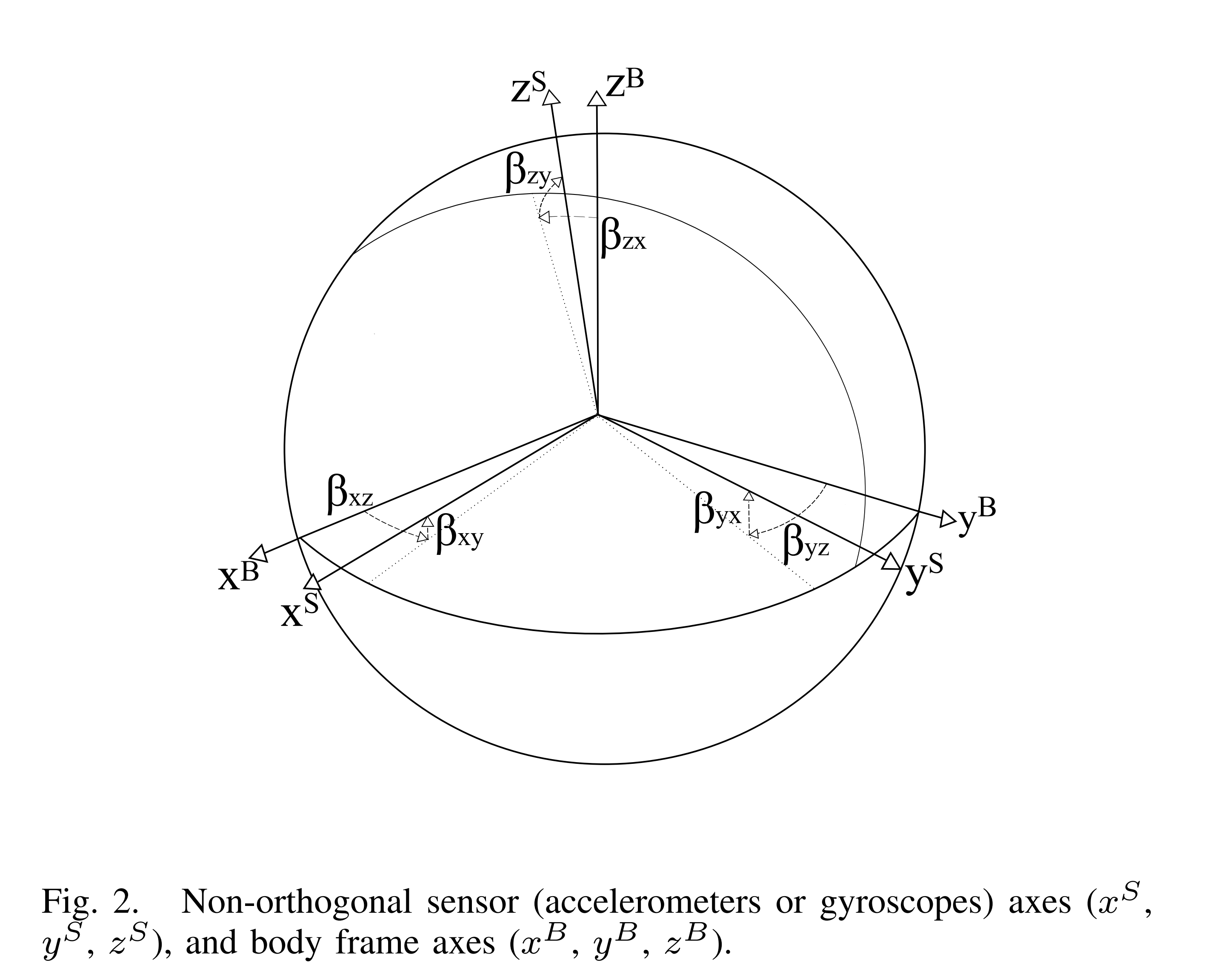

对于 GOF 的建立约束与 AOF 的约束类比建立。最后再建立一个正交机体坐标系 BF,BF 通常与 AF 和 GF 之间有一个小角度的偏差。在非正交坐标系(AF 或 GF)中测量得到的物理量sS可以转换到机体坐标系 BF 中得到sB于是得到下式:

sB=TsS,T=⎣⎢⎡1βxz−βxy−βyz1βyxβzy−βzx1⎦⎥⎤(1)

sB和sS 表示加速度或角速度在机体坐标系 BF 和加速度坐标系 AF 或陀螺仪坐标系 GF 下测量表示量,βij 表示加速度或陀螺仪的 i 轴绕机体坐标系 BF 的 j 轴的旋转角度。如图二所示:

另外 BF 与 AOF 以及 BF 与 GOF 坐标系之间只有纯粹的旋转关系,我们假设 BF 的 x 轴恰巧与 AOF 的 x 轴重合在这种情况下βxz,βxy,βyx变为 0 因此上一式可以写为如下:

aO=TaaS,Ta=⎣⎢⎡100−αyz10αzy−αzx1⎦⎥⎤(2)

这里aO和aS表示加速度在 AOF 和 AF 坐标系下的表示。这里已经改变了β的含义,用α来表示在 AF 与 AOF 的 x 轴重合的情况下 AF 与 AOF 各轴之间的旋转情况而不再是与机体坐标系 BF 之间的旋转关系了。

如前所述,陀螺仪可以按照同样的方式进行定义,

wO=TgwS,Tg=⎣⎢⎡1γxz−γxy−γyz1γyxγzy−γzx1⎦⎥⎤(3)

注意到目前为止要重点区分 5 个坐标系,首先是加速度计坐标系 AF 和陀螺仪坐标系 GF 由于制造工艺的原因这两个坐标系都不是正交的,且这两个坐标系也不重合,然后根据 AF 和 GF 分创建了两个正交坐标系 AOF 和 GOF,建立的约束就是上文中提到的,最后又建立了一个机体坐标系。后面我们假设机体坐标系的 x 轴与加速度正交坐标系 AOF 的 x 轴重合于是建立了加速计方程(1)和(2)最后 BF 与 GOF 的 x 轴不重合因此只有第一步公式(3)没有后续的推导。

综上加速度计和陀螺仪的误差都是包含两部分比例误差 scale 和 0 偏误差 bias,比例偏差 scale 用如下表示:

Ka=⎣⎢⎡sax000say000saz⎦⎥⎤,Kg=⎣⎢⎡sgx000sgy000sgz⎦⎥⎤(4)

两个 bias 向量用如下表示:

ba=⎣⎢⎡baxbaybaz⎦⎥⎤,bg=⎣⎢⎡bgxbgybgz⎦⎥⎤(5)

完整的加速度误差模型如下:

aO=TaKa(aS+ba+va)(6)

完整的角速度误差模型如下:

wO=TgKg(wS+bg+vg)(7)

其中va和vg不是系统误差是测量噪声。到此 IMU 的误差模型就讲清楚了,后面会基于这个误差模型进行建模校准传感器。

校准框架

为了校准加速度计我们需要估计如下未知参数:

θacc=[αyz,αzy,αzx,sax,say,saz,bax,baybaz](8)

我们定义如下函数:

aO=h(aS,θacc)=TaKa(aS+ba)(9)

实际上是忽略了测量噪声。像传统的多位置方案中,我们移动 IMU 到 M 个不同的临时稳定状态,可以提取加速度向量akS(在非正交坐标系 AF 中)计算加速度计在每个静止状态下的平均值,使用如下代价方程来估计加速度计的参数:

L(θacc)=k=1∑M(∣∣g∣∣2−∣∣h(akS,θacc)∣∣2)2(10)

∣∣g∣∣是真实的当地重力加速度计,可以根据当地的经纬度非常容易的获取到,我们采用 Levenberg-Marquardt 方法来求取当代价函数的最小值时的参数。

为了校准陀螺仪我们可以在 IMU 初始的静止阶段读取陀螺仪数据并取均值,作为陀螺仪 bias。

我们定义Ψ操作,用读取的陀螺仪数据wiS和重力向量ua,k−1作为输入队列(重力向量是经过上面步骤校准过的)该操作返回最终的重力向量ug,k。该操作可以是任意一个通过上一时刻加速度计与角速度计融合后得到当前重力向量的算法。

ug,k=Ψ(wiS,ua,k−1)(11)

我们需要估计的未知陀螺仪参数如下:

θgyro=[γyz,γzy,γxz,γzx,γxy,γyx,sxg,syg,szg](12)

在这种情况下我们定义代价函数:

L(θgyro)=k=2∑M∣∣ua,k−ug,k∣∣2(13)

M 是静态状态读取数据的数量ua,k是加速度计计算得到的重力向量,ug,k是通过(13)式计算得到的,我们要获得θgyro的最小值同样采用上面提到的 Levenberg-Marquardt 方法来求取。

校准过程

静态检测

如前面校准框架所述,校准 IMU 需要收集加速度计和陀螺仪的原始数据,采集的数据应该包含 IMU 在各个稳定状态及其间隔状态下的数据。为了减小 bias 噪声对上面两个代价函数的影响需要先对 0 偏进行校准,初始阶段需要一段时间的静止用于校准陀螺仪的 bias 以及用于静态检测参考。

校准精度取决于对静止状态判断的准确性,校准加速度计需要在几个静态状态下进行运算,校准陀螺仪需要静态以及各个不同状态的静态之间的运动数据。根据经验对实际的数据集采用基于滤波的算子效果会较差,例如准静态检测器,检测静止状态通常会包含一些小的运动。而且基于滤波器的算法通常依赖滤波参数,需要对滤波参数进行调整。

我们建议采用基于方差的静态检测器运算,他利用上面的静态检测间隔。我们的检测器基于twait时间间隔进行采集加速度信号并计算方差大小:

ζ(t)=[vartw(axt)]2+[vartw(ayt)]2+[vartw(azt)]2(14)

其中vartw(at)是以时间 t 为中心每隔时间间隔tw加速度信号的方差值,我们要对该状态进行分类为静止还是运动只需要对ζ(t)跟一个阈值进行比较就可以了。这个阈值我们可以选取 IMU 在初始静止状态下的值ζ(init),从而不依赖任何外部参数的调整。

龙格库塔法积分

在上面的 11 式中,通过 k-1 时刻的加速度计得到的重力向量与 k-1 到 k 时刻的加速度进行运算得到 k 时刻的重力向量,这里 k-1 和 k 是两个稳定状态,因此 k-1 和 k 之间有一段时间的运动,需要对陀螺仪数据进行积分到加速度计的重力向量中去,在我们的实验中采用 4 阶龙格库塔积分法(RK4n)比标准线性积分精度要高,下式 15 用微分方程来描述四元数运动方程:

f(q,t)=q˙=21Ω(w(t))q(15)

这里 q 是 t-1 时刻的重力向量的四元数表示,而Ω(w)是将角速度转化为斜对称旋转矩阵的操作,形式如下:

Ω(w)=⎣⎢⎢⎢⎡0wxwywz−wx0−wzwy−wywz0−wx−wz−wywx0⎦⎥⎥⎥⎤(16)

RK4n 算法如下:

qk+1=qk+Δt61(k1+2k2+2k3+k4)(17)

ki=f(q(i),tk+ciΔt)(18)

q(i)=qk,fori=1(19)

q(i)=qk+Δtj=1∑i−1aijkj,fori>1(20)

所有需要的系数ci和aij为:

c1=0,c2=21,c3=21,c4=1,a21=21,a31=0,a41=0,a32=21,a42=0,a43=1.

最后对于每一步我们需要归一化四元数 q:

qk+1→∣∣qk+1∣∣qk+1(21)

阿伦方差

我们使用艾伦方差来表示陀螺仪的随机漂移误差,这里用δa2来衡量连续间隔陀螺仪数据平均值之间的方差:

δa2=<(x(t~,k)−x(t~,k−1))2>=2K1k=1∑K(x(t~,k)−x(t~,k−1))2(22)

其中x(t,k)是第 k 个t~时间间隔陀螺仪数据的均值,K 是所有时间的t~个数,我们对每一个轴计算阿伦方差,当阿伦方差收敛到很小的一个值时就表示校准 ok 了,在初始阶段我们将对陀螺仪数据进行求阿伦方差进行校准。

完成校准

为了得到较好的校准结果至少需要 9 种不同姿态的数据,实验表明姿态数越多校准结果越好。

附录

Levenberg-Marquardt 算法

牛顿法

牛顿法(英语:Newton’s method)又称为牛顿-拉弗森方法(英语:Newton-Raphson method),它是一种在实数域和复数域上近似求解方程的方法。方法使用函数f(x)的泰勒级数的前面几项来寻找方程f(x)=0的根。

算法过程:

首先选择一个接近函数f(x)零点的x0, 计算相应的f(x0)和切线斜率f′(x0),然后计算穿过点(x0,f(x0))并且斜率为f′(x0)的直线和x轴的交点的x坐标,也就是求如下方程的解:

0=(x−x0)⋅f′(x0)+f(x0)

我们求解 x,过程如下:

0=(x−x0)+f′(x0)f(x0)x−x0=−f′(x0)f(x0)x=x0−f′(x0)f(x0)

我们将新求得的点x坐标命名为x1,通常x1会比x0更接近方程f(x)=0的解,因此我们可以利用x1开始下一轮的迭代,迭代公式如下:

xn+1=xn−f′(xn)f(xn)

对于多维的情况,对f(x)在x0处进行二阶泰勒展开:

f(x)=f(x0)+▽f(x0)T(x−x0)+21(x−x0)TH(x0)(x−x0)

这里▽f(x0)是f(x)的梯度向量在点x0处的值;H(x0)是f(x)的海塞矩阵在点x0处的值,函数f(x)有极值的必要条件是在极值点处一阶导数为 0.

利用极小点的必要条件▽f(xk)=0每次迭代从xk开始求目标函数的极小点,作为第k+1次迭代值xk+1

假如xk+1满足▽f(xk+1)=0对▽f(x)进行泰勒展开:

▽f(x)=▽f(xk)+H(xk)(x−xk)▽f(xk)+H(xk)(xk+1−xk)=0xk+1=xk−H(xk)−1▽f(xk)

可以写为如下:

xk+1=xk−Hk−1gk

这就是牛顿法的多维公式,其中gk=▽f(xk)

imu 算法 [[imuAttitudeCalculation]]

高斯-牛顿法

给定 m 个方程r=(r1,r2,...rm)(通常叫做残差方程)和 n 个变量β=(β1,β2,...βn), 其中m⩾n, 高斯-牛顿算法迭代找出下式取最小值时的最优值。

s(β)=i=1∑mri(β)2

从给定初始值β0开始,通过下式进行迭代寻找s(β)的最小值:

βs+1=βs−(JrJr)−1JrTrβs

这里r和β都是列向量,JrJacobian matrix 为:

(Jr)ij=∂βj∂riβs

其中符号T是 matrix transpose. 如果 m=n 则可以简化为如下:

βs+1=βs−(Jr)−1rβs

这就是一维牛顿法的直接推广。

在数据拟合中,目标是找到最佳参数β使得β满足给定模型y=f(x,β)可以最好的符合数据点(x,y), 方程r是残差方程,如下:

ri(β)=yi−f(xi,β)

高斯-牛顿法可以用函数f的雅克比Jf表示:

βs+1=βs−(JfJf)−1JfTrβs

这里(JfJf)−1JfT是Jf的伪逆(摩尔-彭罗斯逆)。

高斯-牛顿算法将通过近似从牛顿方法优化函数中推导而来。牛顿方法最小化参数函数s的递归关系β为:

βs+1=βs−H−1g

其中g表示S梯度向量,H表示S的海塞矩阵 ( Hessian matrix). 由于S=∑i=1mri∂βj∂ri其梯度通过下式给出:

gj=2i=1∑mri∂βj∂ri

海塞矩阵H的元素通过梯度gj的不同元素βk计算得到:

Hjk=2i=1∑m(∂βj∂ri∂βk∂ri+ri∂βj∂βk∂2ri)

高斯-牛顿法忽略二阶小项,海塞矩阵H可以近似写为:

Hjk≈2i=1∑mJijJik

这里Jij=∂βj∂ri是雅克比矩阵Jr的一项,梯度和海塞矩阵可以通过如下符号来表示:

g=2JrTr,H≈2JrTJr

将这些表达式代入上述递归关系中以获得运算方程式就得到:

β(s+1)=β(s)−(JrTJr)−1JrTr(β(s))

注意并非在所有情况下都保证高斯-牛顿法的收敛性,下式要能够得到保证才可以:

∣∣∣∣∣ri∂βj∂βk∂2ri∣∣∣∣∣≪∣∣∣∣∣∂βj∂ri∂βk∂ri∣∣∣∣∣

二阶导数足够小可以被忽略,在如下两种情况下都会收敛:

1.ri在选取值附近要足够小,至少在最小值附近要足够小。

2. 函数只有轻度的非线性,因此$\frac{\partial^2 r_i}{\partial \beta_j \partial \beta_k} $在选取值附近才会足够小。

Levenberg-Marquardt 算法

莱文贝格-马夸特方法(Levenberg–Marquardt algorithm)能提供数非线性最小化(局部最小)的数值解。、

和其他最小化算法一样,LM 算法也是采用迭代过程,首先也是要提供一个参数β的猜测值,在只有一个最小值的情况下初始猜测参数为βT=(1, 1, …, 1)也可以很好的工作,在有多个极小值的情况下仅当猜测值以及接近最终解时,算法才会收敛到全局最小值。在每一步迭代中参数向量β用新的评估值β+δ替代之前的值,为了确定δ函数f(xi,β+δ)需要近似线性化。

f(xi,β+δ)≈f(xi,β)+Jiδ

其中:

Ji=∂β∂f(xi,β)

是函数f对参数β的梯度。

s(β) 平方偏差之和在 f对β 的梯度为 0 时取最小值,上面是 f(xi,β+δ) 的一阶近似,则:

S(β+δ)≈i=1∑m[yi−f(xi,β)−Jiδ]2

或者用向量符号表示:

S(β+δ)≈∥y−f(β)−Jδ∥2=[y−f(β)−Jδ]T[y−f(β)−Jδ]=[y−f(β)]T[y−f(β)]−[y−f(β)]TJδ−(Jδ)T[y−f(β)]+δTJTJδ=[y−f(β)]T[y−f(β)]−2[y−f(β)]TJδ+δTJTJδ.

这里暂时先不做理论推导了,目前没找到好的推导方法,直接上结论吧,

(μI+(JTJ))δp=JTϵk

就是莱文贝格-马夸特方法。如此一来 μ 大的时候这种算法会接近最速下降法,小的时候会接近高斯-牛顿方法。为了确保每次 ϵ 长度的减少,我们这么作:先采用一个小的 μ ,如果 ϵ 长度变大就增加 μ 。这个算法当以下某些条件达到时结束迭代:

- 如果发现 ϵ 长度变化小于特定的给定值就结束。

- 发现 δp 变化小于特定的给定值就结束。

- 到达了迭代的上限设定就结束。

参考文献

《A Robust and Easy to Implement Method for IMU Calibration without External Equipments》

[[imuAttitudeCalculation]]

)